Über FotoPRO.world wurde ich heute auf eine Stellungnahme des Deutschen Fotorats aufmerksam, in der vor der Verwendung von KI-generierten Bildern in der Berichterstattung gewarnt wird. Hier heißt es unter anderem:

Der aktuelle Nahostkonflikt hat zu einem enormen Anstieg im Angebot von KI-generiertem Bildmaterial geführt, das sich auf diese Ereignisse bezieht. Diese mutmaßlichen Kriegsbilder sind in vielen Fällen weder für Fachleute noch mit technischen Systemen zur Erkennung von KI-Bildern von authentischen

Fotos zu unterscheiden.Unter dem Schlagwort „Gaza“ findet man beispielsweise auf der Plattform von Adobe Stock, einer der führenden Bilddatenbanken, KI-generierte fotorealistische Bilder von zerstörten Städten, hoch emotionale Bilder von Kindern in Trümmerlandschaften oder Portraits von bärtigen Bewaffneten, die in der

deutscher-fotorat.de/2023/11/23/fotorat-warnt-vor-irrefuehrenden-ki-bildern-in-der-berichterstattung/

Bildbeschreibung als „Hamas-Krieger“ bezeichnet werden.

Die Bilder werden gleichrangig mit echtem Fotomaterial angeboten, identisch verschlagwortet und in vielen Fällen inhaltlich ähnlich beschrieben. Die Gefahr ist hoch, dass beim Erwerb solcher Bilder, trotz KI-Hinweis beim Anbieter, Kennzeichen der künstlichen Generierung in den weiteren Redaktions-Prozessen

bis zur Veröffentlichung übersehen oder gar ignoriert werden. Wenn KI-Bilder gemeinsam mit Fotos im gleichen Umfeld veröffentlicht werden, suggeriert es Authentizität der synthetischen Bilder und schwächt die Glaubwürdigkeit der realen Fotos.

Allein der Verdacht auf irreführende KI-Bilder im Journalismus löst bei MediennutzerInnen einen unumkehrbaren Vertrauensverlust aus. Der Deutsche Fotorat hat bereits im April mit seinem Positionspapier zu KI auf die Gefahren für den gesellschaftlichen Diskurs hingewiesen.

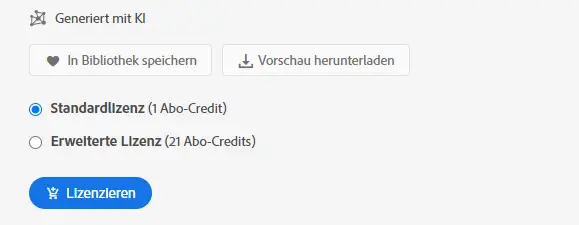

Ich hatte unlängst ebenfalls schon einen Artikel geschrieben, der sich grob mit dieser Thematik auseinandersetzt. Und tatsächlich fällt mir vermehrt auf, dass sich beispielsweise bei Adobe Stock die Zahl der Bilder mehrt, die mit “Generiert mit KI” gekennzeichnet sind.

Ich möchte nicht wissen, wie viele Bilder allerdings nicht gekennzeichnet sind und den Eindruck erwecken, echte Fotos zu sein. An dieser Stelle: Das Titelbild dieses Beitrages wurde ebenfalls mit Hilfe einer KI generiert.

Für jemanden, der selbst Zugriff auf die Stock-Datenbanken hat, ist mit ein wenig Aufmerksamkeit oftmals erkennbar, wenn es sich um ein KI-generiertes Bild handelt. Zudem lassen sich (zumindest bei Adobe Stock, andere habe ich nicht getestet), derartige Bilder per Filter ausschließen. Aber diese Möglichkeiten stehen einem “Konsumenten” von Nachrichten nicht zur Verfügung. Dieser muss darauf vertrauen können, dass die gezeigten Bilder echt sind.

Ein Problem dabei ist jedoch: Selbst wenn seriöse Medien konsequent kein Bild- oder Videomaterial verwenden, das künstlich erzeugt wurde – andere verzichten möglicherweise nicht darauf. Und gerade zu Propagandazwecken lässt sich derartiges Material hervorragend verwenden. Es ist einfacher denn je, passend zu einer gewünschten Aussage Bilder zu generieren. Bestimmt Gruppierungen waren schon immer groß darin (ich denke nur an viele unterschiedliche Bilder, auf denen ein und dieselbe Person mal als Opfer, mal als Helfer etc. zu sehen ist, im Laufe der Jahre in vielen unterschiedlichen angeblichen Situationen). Wenn man diese Aufnahmen sogar komplett ohne Know How einfach für einen kleinen Betrag direkt herunterladen kann – um so “besser”.

Der Aufruf des Deutschen Fotorats ist auf jeden Fall richtig und wichtig. Und wir müssen hoffen, dass sich zumindest die seriösen Medien auch korrekt verhalten. Alle anderen wird dieser Aufruf allerdings leider wenig tangieren. X (vorm. Twitter), Telegram und Co. werden recht wahrscheinlich auch in Zukunft mit derartigen Fakes geflutet werden. Was nicht schlimm wäre, gäbe es nicht die Gruppe derjenigen, die diesen Kanälen deutlich mehr Vertrauen schenken als allen anderen Medien.

Kommentieren